卒業研究のご紹介

2020年版

機械・自動車・ロボット系所属学生

日常生活支援ロボットの開発

高橋 祐史神奈川県

大学院ロボット・メカトロニクスシステム専攻 博士前期課程 2020年3月修了

(創造工学部ロボット・メカトロニクス学科 2018年3月卒業)

(創造工学部ロボット・メカトロニクス学科 2018年3月卒業)

三浦学苑高等学校出身

研究の目的

本研究は、4車輪型双腕ロボットに視覚センサを搭載した日常生活支援ロボットの開発を目的とします。近年ロボットは工場だけでなく、日常生活の中で動作するロボットが多く開発されています。掃除などの特定の作業を行うロボットはありますが、多種多様な作業を行うロボットはまだ実用化されていません。今後、日常生活の中で様々な作業を行うロボットが期待されています。このような日常生活支援ロボットの開発を促進するために、いくつかのロボット競技会が行われており、例えばフューチャーコンビニエンスストアチャレンジでは、未来のコンビニエンスストアを想定した競技であり、ロボットが商品の陳列・廃棄を行うタスク、接客を行うタスク、トイレ清掃を行うタスクがあります。フューチャーコンビニエンスストアチャレンジへの出場を視野に入れ、棚に置かれた対象物を掴み取るロボットを開発します。

研究内容や成果等

■ システム構成

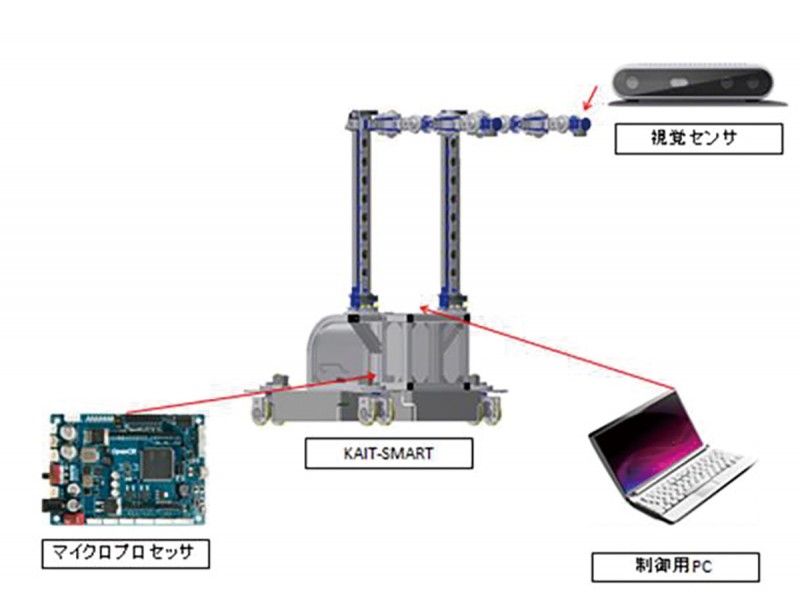

本システムの構成は、開発した生活支援ロボット(KAIT-SMART)、制御用PC、視覚センサ、マイクロプロセッサからなる。マイクロプロセッサはKAIT-SMART内部、視覚センサはKAIT-SMARTのアーム部の先端に搭載する。視覚センサで得た情報を元に対象物であるおにぎりを認識し、ロボットが対象物を把持できるようにアプローチ動作を行い、対象物を把持する。ハードウェア構成を図1に示す。

本研究では対象物を認識させるために機械学習を用いた。機械学習はクラウド上で行い、学習結果のファイルをダウンロードし、ROS(Robot Operating System)上で起動する対象物認識を行うソフトウェアに組み込む。実際にロボットを動作させるプログラムはROS上で行う。

■ 対象物認識について

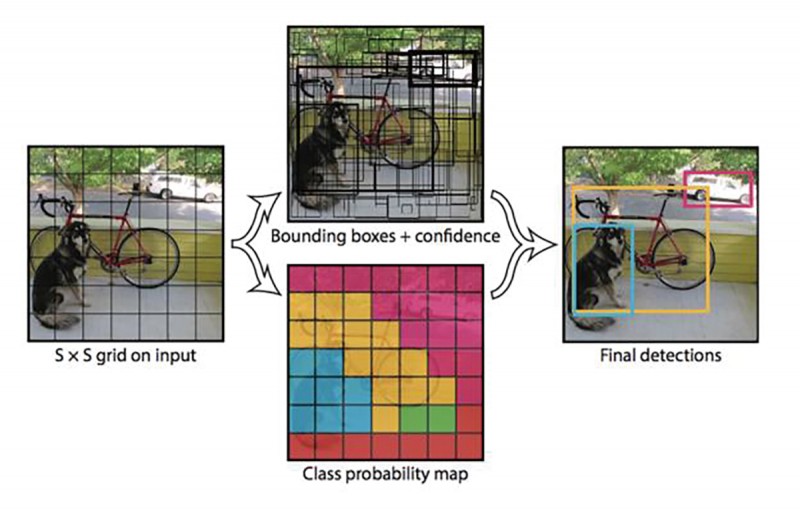

認識対象物はおにぎりとした。本研究では物体認識のシステムとして、機械学習による物体認識の手法の1つYOLO(You Only Look Once)を用いた。YOLOの特徴は、物体と思われる領域を検出することと、その領域が何の物体かの判断を行う識別処理を同時に行うことができ、処理時間を短くすることができる。まず、公開されているYOLOを用いたパッケージであるdarknetをダウンロードする。本研究では機械学習を行うにあたり、教師データ作成のために対象物が映った画像を約100枚用意し、その画像データにフィルタをかけ、画像の向きを変えるなどの加工を行い、画像データを約4000枚に増やした。学習を行うにあたり、Google Colaboratoryを利用した。Colaboratoryとは、完全にクラウドで実行されるJupyterノートブック環境であり、無料でGPUを利用することができる。今回は、学習で使用するデータをアップロードし、Colaboratory上で機械学習を行った。YOLOの認識の流れを図2に示す。

■ 動作実験

(1)対象物が2つの認識実験

対象物が複数ある場合、目的とする対象物を正しく認識できるか実験を行った。対象物であるおにぎりを2つとし、種類は機械学習時に教師データとした梅おにぎりと教師データに加えていない鮭おにぎりの2種類とした。対象物から400mm離れた位置に視覚センサを設置し、対象物から横に100mm離れた位置にもう1つ対象物を設置し、対象物認識のシステムを起動する。600mm、800mm、1000mmの位置でも同様に実験を行う。実験より、2つの対象物を完全に認識したのは、400mmと600mmの位置である。800mmの位置では対象物をどちらか一方しか認識できないことが多く、1000mmの位置では2つとも認識ができない結果であった。複数の対象物の認識率を改善する方法としては、機械学習時の教師データに複数の対象物が映っている画像を加えることが有効だと考える。また、機械学習時に教師データとして使用した梅おにぎりの尤度は、機械学習時に教師データに含めていない鮭おにぎりより90%の割合で梅おにぎりの尤度が高いという結果になった。このことから、尤度の違いによっておにぎりの種類を判別できると考える。

(2)対象物へのアプローチ動作実験

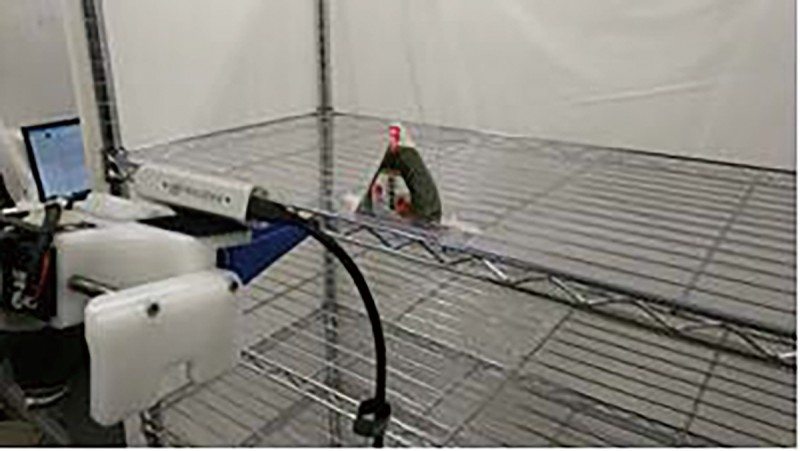

1つの対象物へのアプローチ動作実験を行った。フューチャーコンビニエンスストアチャレンジの規定で定められた陳列棚を用意した。背景が映りこまないように棚の背面に白いシートを覆った。KAIT-SMARTと棚との距離を約800mmの位置に配置する。対象物を棚の最上段に配置し、プログラムを動作させた。今回の実験では、対象物の配置を4パターンに分けた。アーム部に取り付けられた視覚センサの正面、右にずれた位置と左にずれた位置の3パターンと、対象物の向きを90°回転させた横向きでセンサ正面に配置する1パターンである。実験風景を図3に示す。

対象物が複数ある場合、目的とする対象物を正しく認識できるか実験を行った。対象物であるおにぎりを2つとし、種類は機械学習時に教師データとした梅おにぎりと教師データに加えていない鮭おにぎりの2種類とした。対象物から400mm離れた位置に視覚センサを設置し、対象物から横に100mm離れた位置にもう1つ対象物を設置し、対象物認識のシステムを起動する。600mm、800mm、1000mmの位置でも同様に実験を行う。実験より、2つの対象物を完全に認識したのは、400mmと600mmの位置である。800mmの位置では対象物をどちらか一方しか認識できないことが多く、1000mmの位置では2つとも認識ができない結果であった。複数の対象物の認識率を改善する方法としては、機械学習時の教師データに複数の対象物が映っている画像を加えることが有効だと考える。また、機械学習時に教師データとして使用した梅おにぎりの尤度は、機械学習時に教師データに含めていない鮭おにぎりより90%の割合で梅おにぎりの尤度が高いという結果になった。このことから、尤度の違いによっておにぎりの種類を判別できると考える。

(2)対象物へのアプローチ動作実験

1つの対象物へのアプローチ動作実験を行った。フューチャーコンビニエンスストアチャレンジの規定で定められた陳列棚を用意した。背景が映りこまないように棚の背面に白いシートを覆った。KAIT-SMARTと棚との距離を約800mmの位置に配置する。対象物を棚の最上段に配置し、プログラムを動作させた。今回の実験では、対象物の配置を4パターンに分けた。アーム部に取り付けられた視覚センサの正面、右にずれた位置と左にずれた位置の3パターンと、対象物の向きを90°回転させた横向きでセンサ正面に配置する1パターンである。実験風景を図3に示す。

実験より、アプローチ動作の成功率は平均約67%であった。対象物がハンドの正面にあり、正対向きであれば100%正しいアプローチ動作を行うことができた。誤ったアプローチ動作を行った原因は、対象物の誤認識や認識不能といったことが原因である。成功率を上げるためには、機械学習の教師データを再設定する必要がある。

(3)対象物把持実験

2パターンの対象物を把持できるか実験を行った。

対象物へのアプローチ動作実験と同じ環境とする。対象物の配置は、視覚センサの正面に配置するパターンと対象物の向きを90°回転させた横向きで視覚センサ正面に配置するパターンの2パターンに分けた。実験より、対象物把持の成功率は平均約33%であった。対象物が正対向きの場合は,正しくアプローチ動作を行うことはできたが,アプローチ動作中に対象物を倒してしまい把持することができないことが多かった。対象物が横向きの場合は、アプローチ動作で対象物を倒すことなく把持することができたが、認識時に対象物を認識できないことが多かった。

(3)対象物把持実験

2パターンの対象物を把持できるか実験を行った。

対象物へのアプローチ動作実験と同じ環境とする。対象物の配置は、視覚センサの正面に配置するパターンと対象物の向きを90°回転させた横向きで視覚センサ正面に配置するパターンの2パターンに分けた。実験より、対象物把持の成功率は平均約33%であった。対象物が正対向きの場合は,正しくアプローチ動作を行うことはできたが,アプローチ動作中に対象物を倒してしまい把持することができないことが多かった。対象物が横向きの場合は、アプローチ動作で対象物を倒すことなく把持することができたが、認識時に対象物を認識できないことが多かった。

■ 結論

本研究により以下の結果を得た。

1. 生活支援ロボット”KAIT-SMART”を開発した。

2. YOLOによる機械学習を用いて対象物の認識,対物の座標取得及び矩形領域生成,矩形領域内の平均距離算出を行った。

3. 対象物認識システムとKAIT-SMART制御システムを連動させ、対象物把持の実験を行った。

4. 実験より、1つの対象物の認識成功率は平均96%、2つの対象物の認識成功率は平均55%、対象物へのアプローチ動作実験の平均成功率は66%、対象物把持の平均成功率は33%であった。

1. 生活支援ロボット”KAIT-SMART”を開発した。

2. YOLOによる機械学習を用いて対象物の認識,対物の座標取得及び矩形領域生成,矩形領域内の平均距離算出を行った。

3. 対象物認識システムとKAIT-SMART制御システムを連動させ、対象物把持の実験を行った。

4. 実験より、1つの対象物の認識成功率は平均96%、2つの対象物の認識成功率は平均55%、対象物へのアプローチ動作実験の平均成功率は66%、対象物把持の平均成功率は33%であった。

-

指導教員からのコメント

ロボット・インタフェース研究室教授 河原崎 徳之

指導教員からのコメント

ロボット・インタフェース研究室教授 河原崎 徳之

- 高橋祐史君が行った“日常生活支援ロボットの開発”は、WRS(World Robot summit)フューチャコンビニエンスストアチャレンジというロボット競技会への出場を目指した研究です。このロボット競技会は、コンビニエンスストアの商品の陳列や廃棄をロボットに行わせるというものです。高橋君は、機械学習による物体認識の手法の1つYOLO(You Only Look Once)を用いて、棚に置かれた“おにぎり“の位置と姿勢を認識することに挑戦し、最後はうまくロボットに”おにぎり“をつかませることができました。高橋君は、非常に研究熱心で、教員にも積極的に相談し、着実に成果を上げていきました。就職したIT関連の会社でも優秀な技術者として活躍されることと思います。

-

修士研究学生からの一言

高橋 祐史

修士研究学生からの一言

高橋 祐史

- 大学院までの6年間で、機械分野や電気・電子分野、情報分野など幅広く授業を受けました。その中でも、研究活動はシステム開発を中心に行っていたので、主にシステム開発関連の授業の経験が研究活動に活かすことができました。研究活動では、思ったように研究が進まないこともありましたが、諦めずに研究を行い、河原崎教授のご指導のもとに研究を終えることができました。ここで培った、諦めずに挑戦した研究活動の経験は、社会人となっても活かすことができると考え、成長することができたと実感しました。

- 創造工学部ロボット・メカトロニクス学科(大学サイト )

- 教員紹介ページ(大学サイト )

- 研究室ナビ(大学サイト)