卒業研究のご紹介

2020年版

機械・自動車・ロボット系所属学生

拡張現実知覚生成技術による実車での安全性評価手法に関する研究

髙山 拓也北海道

大学院機械システム工学専攻 博士前期課程 2020年3月修了

(創造工学部自動車システム開発工学科 2018年3月卒業)

(創造工学部自動車システム開発工学科 2018年3月卒業)

市立札幌藻岩高等学校出身

研究の目的

近年、交通事故原因の約9割がヒューマンエラーであることから、事故防止や被害軽減を目指して、自動運転や先進運転支援システムの需要が増えている。自動運転を実現するには、様々な走行シーンへの対応が必要となる。これらのシステムの開発や評価では、バルーンの車やダミー人形の試験ターゲットを使った実車評価を行っている。しかし、これらの装置では、走行シーンの再現性や実験場で再現評価することに莫大な労力を要する。そこで、本研究では拡張現実知覚(現実環境に仮想情報を加える技術)と実車を用いて、走行シーンの再現とシステム評価環境を併せ持つプラットフォーム:Vehicle in the Loop system(以下、ViL)を構築することを目的とした。

研究内容や成果等

■ システム設計

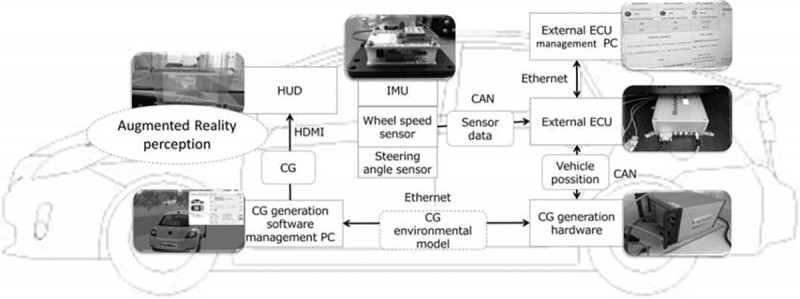

(1)システム概要

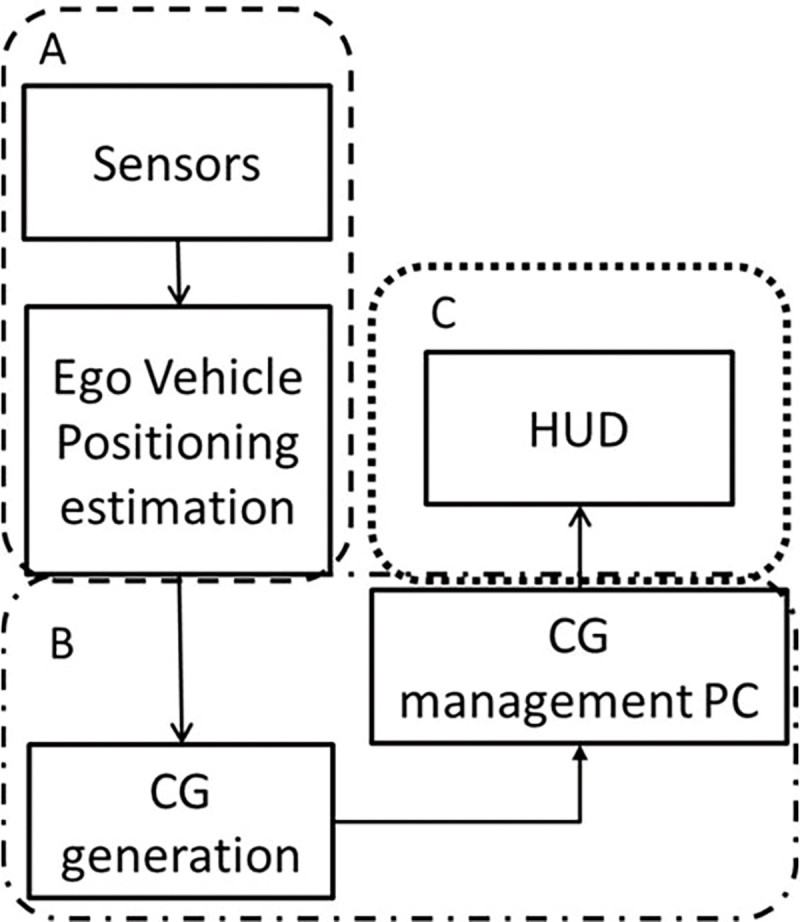

本研究で構築したシステム構成を図1に示す。運転の現実感を高める為に、実車(図2/略)を使い、CG環境の生成には、走行シナリオ再現に優れているバーチャルテストソフトウェアを用いることで、現実感の向上を目指した。自己位置推定には車両標準センサ等からのデータを外部ECUで受け取り、自己位置推定をリアルタイムに算出し、CG環境と現実風景の空間座標を合わせることで、CG環境内の自車両と実際の車両を同じように動作させることができる。

本研究で構築したシステム構成を図1に示す。運転の現実感を高める為に、実車(図2/略)を使い、CG環境の生成には、走行シナリオ再現に優れているバーチャルテストソフトウェアを用いることで、現実感の向上を目指した。自己位置推定には車両標準センサ等からのデータを外部ECUで受け取り、自己位置推定をリアルタイムに算出し、CG環境と現実風景の空間座標を合わせることで、CG環境内の自車両と実際の車両を同じように動作させることができる。

生成したCG環境は、ヘッドアップディスプレイ(以下、HUD)を用いて現実風景に重畳し、その映像を拡張現実知覚(図3)と定義する。

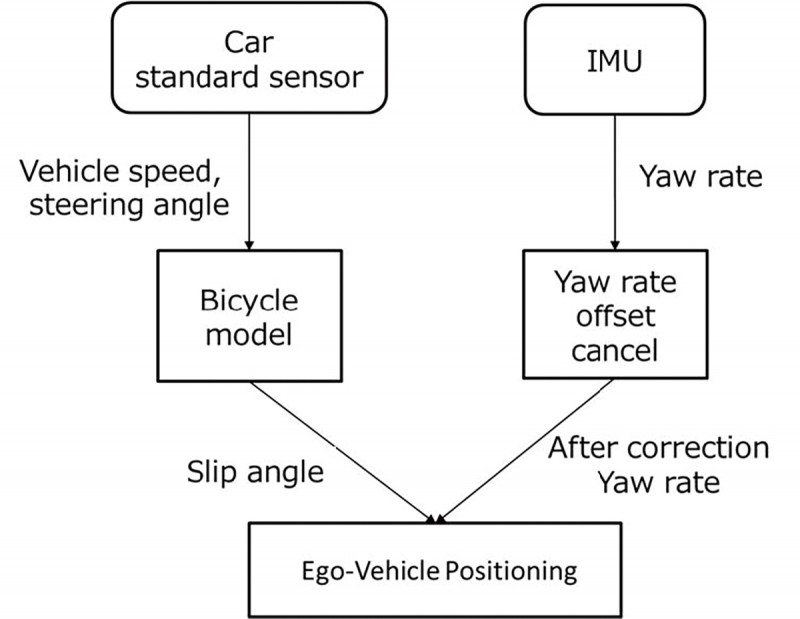

(2)自己位置推定

以下に自己位置推定の概要(図4)を示す。

(2)自己位置推定

以下に自己位置推定の概要(図4)を示す。

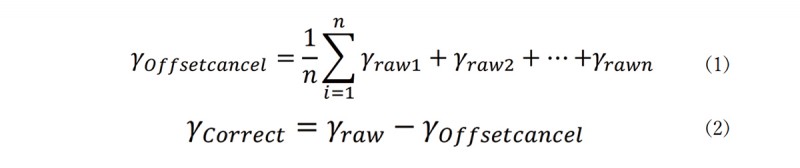

CG生成ソフトウェアでCG環境内の自車両と実際の車両を同じように動作させるには、①自己位置座標Xc、Yc、②ヨー角ψが必要となる。自己位置推定には、ViL構築を簡便化する為内界センサによる自己位置推定手法を選択し、車両に標準搭載されたステアリング角センサと車輪速センサから取得したデータを使用した。ヨーレイトの計測には追加設置した慣性センサ(Inertial Measurement Unit,以下、IMU)を用いた。IMUとは移動体の運動状態を計測可能なセンサである。IMUには停車時の0点誤差や温度ドリフトと呼ばれる変動誤差が存在する。この為、単純なヨーレイトの時間積分によるヨー角算出では積分誤差が生じる。これを軽減させる為に、オフセットキャンセルという温度ドリフトを軽減させ る処理を実装した。これは車両が静止状態であるときのヨーレイト生値γrawをn[sec]計測し、その平均値が補正値γOffcetcancelである。自己位置推定の計算には補正後の値γCorrectを使用し、温度ドリフト補正後にヨー角ψ、自己位置座標Xc、Yc の計算が開始されるようになっている。ヨーレイト補正の算出式を以下に示す。(1)、(2)又、本研究ではn=10secとする。

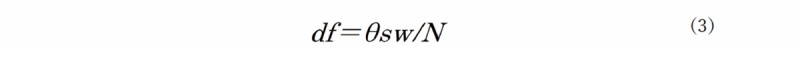

タイヤ実舵角の算出は、ステアリング角θswをステアリングギア比Nで除算したものでタイヤ実舵角の算出式を以下に示す。(3)

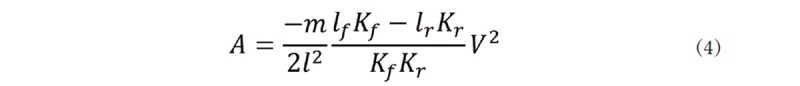

後述の横滑り角β算出で用いるスタビリティファクタAの算出式を以下に示す。(4)

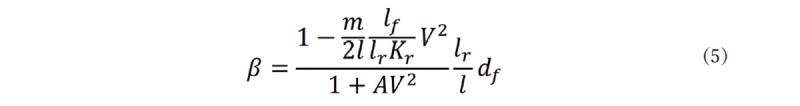

横滑り角βの算出式を以下に示す。(5)

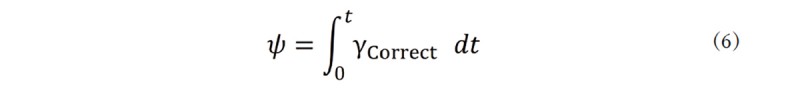

ヨー角の算出式を以下に示す。(6)

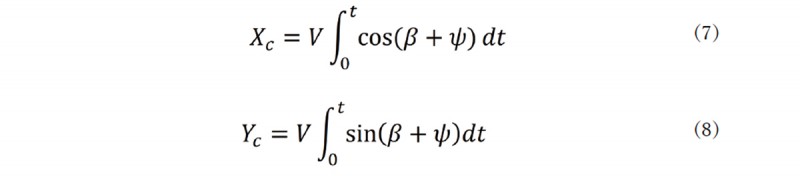

自己位置座標Xc、Ycの算出式を以下に示す。(7)、(8)

以上の式より①自己位置座標Xc、Yc、②ヨー角ψを算出し、CG環境と現実風景の空間座標を合わせた。

■ 映像の遅延要因

拡張現実知覚の生成は、次の手順で行われている。車両等から取得したセンサデータを基に自己位置推定を行う。推定結果をCG 生成ハードウェアへ送信しCG環境を生成する。生成したCG環境はCG生成ソフトウェア管理PCを通してとして、HUD等の映像表示機器へと映像出力する。これらを整理すると、主な映像の遅延要因として、以下の A、B、C、の3点が考えられる。(図 5)

A.自己位置推定の遅延

自己位置推定の算出で使用する値のそれぞれのデータ取得周期は車両が12[ms]とIMUが20[ms]であることが解った。自己位置推定の算出周期は1[ms]で演算しているが、車両運動の基本となるヨーレイトの計測周期は20[ms]である為、本研究では、ViLの自己位置推定の遅延時間は20[ms]と定義した。

B.CG生成の遅延

CG生成の遅延とは、CG生成ハードウェアが自己位置情報を車両から受け取り、CG環境に反映されるまでにかかる時間とした。映像生成にかかる時間を計測する為に、自己位置推定結果の受け取り部に信号を入力してから、環境モデルに反映される時間をカメラで計測した。この結果4.2[ms]以内にCG環境に反映が開始されていることが解った。但し、これらの数値は、カメラの性能や映像表示機器の性能により変化することが考えられる為、本実験車構成の計測値を用い、CG生成の時間遅延は、4.2[ms]とした。

C.映像出力の遅延

映像出力の遅延とは、HUDに映像出力し表示されるまでにかかる時間とした。映像表示にかかる時間を計測する為にPCに時刻を表示し、その映像をHUDに出力する。それぞれの画面に表示された時刻が画角に入るようにカメラで撮影し、再生した際、時間を識別できる瞬間を記録し、それぞれに表示された時間の差分を遅延時間としてカウントした。この結果からPCから映像を出力しHUDに表示する時間遅延を平均すると18[ms]であることが解った。これらのことから、映像出力にかかる遅延時間は18[ms]と定義した。

以上のことから、構築したViLの考えられる視覚映像の遅延要因から推定される遅延時間のA、B、Cの3点の合計は42[ms]となり、自己位置推定からHUDへの拡張現実知覚表示までを適正な応答で出力できるViLを構築できた。

自己位置推定の算出で使用する値のそれぞれのデータ取得周期は車両が12[ms]とIMUが20[ms]であることが解った。自己位置推定の算出周期は1[ms]で演算しているが、車両運動の基本となるヨーレイトの計測周期は20[ms]である為、本研究では、ViLの自己位置推定の遅延時間は20[ms]と定義した。

B.CG生成の遅延

CG生成の遅延とは、CG生成ハードウェアが自己位置情報を車両から受け取り、CG環境に反映されるまでにかかる時間とした。映像生成にかかる時間を計測する為に、自己位置推定結果の受け取り部に信号を入力してから、環境モデルに反映される時間をカメラで計測した。この結果4.2[ms]以内にCG環境に反映が開始されていることが解った。但し、これらの数値は、カメラの性能や映像表示機器の性能により変化することが考えられる為、本実験車構成の計測値を用い、CG生成の時間遅延は、4.2[ms]とした。

C.映像出力の遅延

映像出力の遅延とは、HUDに映像出力し表示されるまでにかかる時間とした。映像表示にかかる時間を計測する為にPCに時刻を表示し、その映像をHUDに出力する。それぞれの画面に表示された時刻が画角に入るようにカメラで撮影し、再生した際、時間を識別できる瞬間を記録し、それぞれに表示された時間の差分を遅延時間としてカウントした。この結果からPCから映像を出力しHUDに表示する時間遅延を平均すると18[ms]であることが解った。これらのことから、映像出力にかかる遅延時間は18[ms]と定義した。

以上のことから、構築したViLの考えられる視覚映像の遅延要因から推定される遅延時間のA、B、Cの3点の合計は42[ms]となり、自己位置推定からHUDへの拡張現実知覚表示までを適正な応答で出力できるViLを構築できた。

■ ViLを用いた安全性評価での効果確認実験

築したViLの拡張現実知覚の走行シナリオにドライバが適正に反応し、安全性評価が可能であるかViLを使って確認した。

(1)実験概要

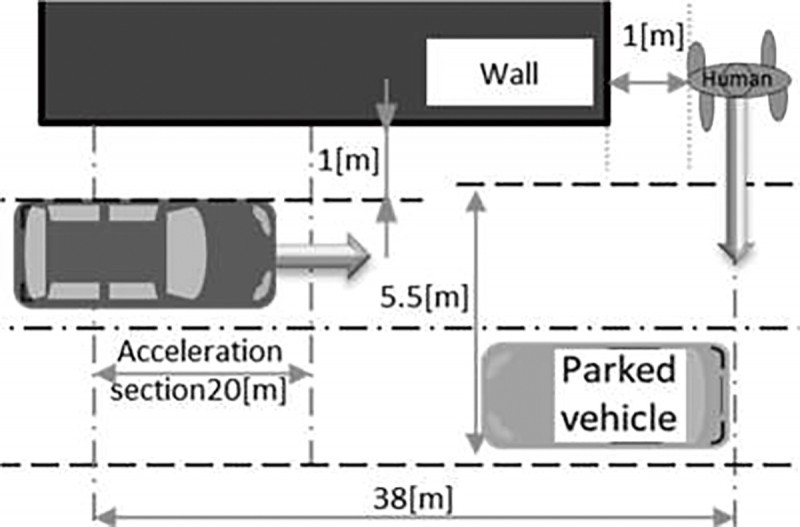

実験の際はインフォームドコンセントに則り、ドライバには実験中に体調が悪くなった場合等、ドライバの意思によりすぐに実験を中止できることを伝え、2シナリオ(図6、7)を実施した。被験者は10人で、ドライバの走行シナリオ認知に対するドライバの予測行動を排除するため1回/1人の走行とした。被験者には歩行者が飛び出してくるかもしれないので通常通りに注意して運転するようにと伝え、自車以外、全てCGで描写し、拡張現実知覚をHUDに提示しながら実施した。Scenario 1は直進時の遮蔽物の陰からの飛び出し歩行者の回避とし、歩行者の飛び出しタイミングを衝突余裕時間(Time to Collision,以下 TTC)が2.0[s]と1.0[s]の2条件、ラップ率50%の位置に立ち尽くす状態で設定し変化させた。この時、拡張現実知覚の走行シナリオの危険度の違いがドライバの運転行動に変化が現れるかを確認した。

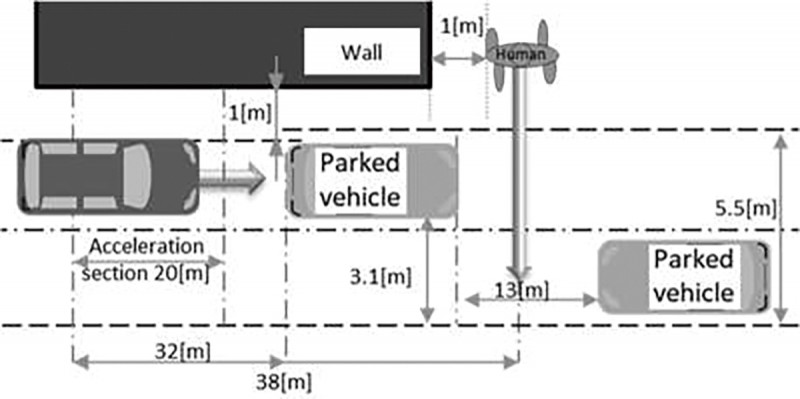

Scenario 2は、駐車車両の追い越し動作中での駐車車両の陰からの飛び出し歩行者の回避とし、歩行者はTTC=2.0[s]の時、ラップ率50%の位置に立ち尽くす状態となる。この時ドライバが拡張現実知覚を見て、知覚、認知、判断、操作の一連の動作がViLにより適正に反応するかを確認した。Scenario 1、2共に、自車速度15[km/h]で歩行者の歩行速度は8[km/h]、歩行者の横断方向については日本の典型的なシーンを想定しドライバから見て左からの横断のみとした。又、歩行速度8[km/h]とは、自動車アセスメントで定められた部分試験評価の歩行速度であり、TTC=2.0[s]とは、歩行者横断ヒヤリハット事例の分析より、移動可能性の無い遮蔽物では概ね2.0[s]前後のTTCで歩行者が飛び出していることから設定した。

(1)実験概要

実験の際はインフォームドコンセントに則り、ドライバには実験中に体調が悪くなった場合等、ドライバの意思によりすぐに実験を中止できることを伝え、2シナリオ(図6、7)を実施した。被験者は10人で、ドライバの走行シナリオ認知に対するドライバの予測行動を排除するため1回/1人の走行とした。被験者には歩行者が飛び出してくるかもしれないので通常通りに注意して運転するようにと伝え、自車以外、全てCGで描写し、拡張現実知覚をHUDに提示しながら実施した。Scenario 1は直進時の遮蔽物の陰からの飛び出し歩行者の回避とし、歩行者の飛び出しタイミングを衝突余裕時間(Time to Collision,以下 TTC)が2.0[s]と1.0[s]の2条件、ラップ率50%の位置に立ち尽くす状態で設定し変化させた。この時、拡張現実知覚の走行シナリオの危険度の違いがドライバの運転行動に変化が現れるかを確認した。

Scenario 2は、駐車車両の追い越し動作中での駐車車両の陰からの飛び出し歩行者の回避とし、歩行者はTTC=2.0[s]の時、ラップ率50%の位置に立ち尽くす状態となる。この時ドライバが拡張現実知覚を見て、知覚、認知、判断、操作の一連の動作がViLにより適正に反応するかを確認した。Scenario 1、2共に、自車速度15[km/h]で歩行者の歩行速度は8[km/h]、歩行者の横断方向については日本の典型的なシーンを想定しドライバから見て左からの横断のみとした。又、歩行速度8[km/h]とは、自動車アセスメントで定められた部分試験評価の歩行速度であり、TTC=2.0[s]とは、歩行者横断ヒヤリハット事例の分析より、移動可能性の無い遮蔽物では概ね2.0[s]前後のTTCで歩行者が飛び出していることから設定した。

(2)実験結果 (図全て略)

図8にScenario 1の速度変化、図9、10、11に Scenario 2の速度、操舵角の変化、走行軌跡を示す。

(3)実験結果の考察

Scenario 1では、運転行動の反応には個人差があるものの走行シナリオの危険度の違いにより減速度が増加する傾向が確認出来た。このことから拡張現実知覚の走行シナリオの危険度の違いが運転行動に変化を与えたと考えられる。

Scenario 2では、駐車車両前で、ステアリング操作を開始し、歩行者前で人間がブレーキを踏み、減速・停車や歩行者と駐車車両の間を通り抜けようとする等の行動が確認できた。このことから拡張現実知覚映像の内容を知覚、認知、判断、操作した行動と考えられる。以上より拡張現実知覚生成技術を使用したViLにより、一般ドライバはリアルな環境状況に近い反応をし、ADASの安全性評価に効果的に使えることが確認できた。

図8にScenario 1の速度変化、図9、10、11に Scenario 2の速度、操舵角の変化、走行軌跡を示す。

(3)実験結果の考察

Scenario 1では、運転行動の反応には個人差があるものの走行シナリオの危険度の違いにより減速度が増加する傾向が確認出来た。このことから拡張現実知覚の走行シナリオの危険度の違いが運転行動に変化を与えたと考えられる。

Scenario 2では、駐車車両前で、ステアリング操作を開始し、歩行者前で人間がブレーキを踏み、減速・停車や歩行者と駐車車両の間を通り抜けようとする等の行動が確認できた。このことから拡張現実知覚映像の内容を知覚、認知、判断、操作した行動と考えられる。以上より拡張現実知覚生成技術を使用したViLにより、一般ドライバはリアルな環境状況に近い反応をし、ADASの安全性評価に効果的に使えることが確認できた。

■ 結言

本研究では、CG環境と実車走行環境を併せ持った拡張現実システムViLを構築した。ViLを用いた実車テストにより拡張現実知覚生成技術を使用したViLが安全性評価に効果的であることが確認できた。今後、シナリオを増やし、実車評価との比較や拡張現実知覚の表示範囲を拡大する等の改善を行い、より精度を上げていく。

-

指導教員からのコメント

自動運転・運転支援研究室教授 井上 秀雄

指導教員からのコメント

自動運転・運転支援研究室教授 井上 秀雄

- 髙山君の研究は、Argument realityを使った大変ユニークな実車でのシステム効果評価技術に関するものです。駐車車両の陰からの歩行者の飛び出しシナリオを、仮想シミュレーション映像の作成と、これを実車走行の動きに同期させることで、前方のリアル視界にあたかも人が飛び出してくる仮想シーンを作り出すことができました。実際のパネラーのテストでも、思わずドライバが操舵やブレーキの回避操作をするので、リアルとバーチャルを併せたArgument reality技術が実システムの評価に使えることが検証できました。高山君が粘り強く、よくぞここまで実現してくれたと感謝しています。今後は、これをフロントガラス上に重畳させる技術を加えて、よりレベルの高い研究として、研究室の後輩が引継ぐ予定です。

-

修士研究学生からの一言

髙山 拓也

修士研究学生からの一言

髙山 拓也

- 自動車が好きで漠然とエンジニアになりたいと思い入学しました。自動車は、多様な分野の技術が集まった製品であり、開発設計には様々な知識が求められます。それらの基礎を学び、専門科目を学んでいく中で、自動車の何をやりたいかが見えてきました。研究の中では、企業の方とのやり取りや実際の企業でも使われる装置・ソフトウェアを使うことで、マナーやスキルを養うことができました。また、研究で実車を使うことやシステムの構築・評価といった大きなテーマに取り組むことができたことは、非常に貴重な経験で、多くの失敗から問題解決能力が身についたと思います。

- 創造工学部自動車システム開発工学科(大学サイト )

- 教員紹介ページ(大学サイト )

- 研究室ナビ(大学サイト)